一场AI变革的风暴,正以超乎想象的速度席卷高校科研领域。

“从大年初二开始,我们就接到很多客户的咨询电话,都在问怎么用DeepSeek模型,构建自己的专属业务场景。”一位高校人工智能服务商告诉数智前线,“其实,这次高校和科研院所反应很快,早在农历年前就有行动。因为DeepSeek是最先在学术圈‘爆炸’,然后扩大到技术应用圈和产业圈。”

DeepSeek不仅把大模型的算力要求大幅降低,还开源免费,最小版本在单个GPU上就能跑起来。以往,大模型对高校师生门槛不低,甚至是遥不可及的“奢侈品”。如今,大学、实验室甚至个人都可以上手了。有大学教授直言,原则上,AI for Science和Science for AI都能大干一场了!

但热情归热情,DeepSeek等开源模型,在高校落地还有不少 “硬茬子”,比如AI复合型人才稀缺、高校算力跟不上、技术栈复杂得让人头疼。

针对高校AI落地瓶颈,业界正从过去单纯的“堆算力”,转而追求一个更高效的系统。其中,百度正在以更全栈化的支持,携手国内18家头部高校,打造出AI for Science的实战攻略,破解高校AI落地难题。

01

高校需求来得又快又猛

“一夜之间,我们好像就从‘iPhone一代’直接跨到了‘iPhone4s’时代。”一位科研行业人士说,DeepSeek让大家突然感觉到,原来AI来得这么快,离我们的生活工作如此近。“以前,很多学校老师对大模型只是抱着试试看的态度,如今,变成大家都有强烈的信心和动力——我要把它用起来。”

性能水平高的开源模型,让高校和科研院所既可以针对专业方向进行训练,开展AI for Science;也能将模型深入剖析,进行Science for AI的探索。这无疑具有革命性和标志性意义。

实际上,这一轮高校和科研机构对AI for Science的需求,来得迅猛且强烈。

“理论上,DeepSeek将AI课题成本降低到原来的10%,考虑工程化及与其他大小模型的融合,成本大概是原来的1/4。”上述服务商说。

成本的大幅降低,使得AI的应用范围从原本的重点院校和科研机构,迅速拓展到更多长尾市场,如双非院校。而且,项目经费的降低,让审批流程也更加灵活,如今学院甚至老师个人都有一定决策权,这让应用场景打开更多,已出现了井喷。

多所高校已积极投身AI for Science的实践。

天津大学举办专题报告会,教授们详细拆解了大模型从科学假设生成、代码开发、到实验验证及论文撰写的实践路径,认为新的科研范式已经到来。

上海交大赵海教授去年果断弃用GPT-4,改用DeepSeek-V3生成合成数据,开发垂类大模型,原因是DeepSeek-V3性能与GPT-4处于同一量级,而价格只有十分之一。

西安交大已探讨能源与DeepSeek为代表的开源模型的结合。能源行业需要开发垂直大模型,其中许多场景,需要在有限资源下进行本地部署,且能源事关国计民生,可靠性和安全性要求极高。DeepSeek等开源模型或其“蒸馏”的小模型,能通过额外训练提升其能力,可本地部署、保障安全,展现了应用潜力。

中国教科院已将DeepSeek-V3升级到R1,为科研人员提供智能文献整理分析、跨学科交叉研究辅助,以及数据驱动的科研支持。有数据显示,模型效果提升,科研人员借助其进行文献阅读、数据挖掘、论文撰写的周期能缩短30%-50%。

同济大学此前已在调用文心大模型。最近,将通过百度智能云千帆大模型平台,接入并调用DeepSeek-R1/V3 系列模型,进一步完善部分应用场景。

浙江大学生命科学研究院研究人员把DeepSeek当作“交叉学科顾问”。虽然它在单一领域比不上专业学者,但在多领域涉猎上达到了博士生水平。

DeepSeek推动更多大模型走上开源之路。百度宣布,文心大模型4.5系列将于6月30日开源,文心一言也将在4月全面免费。

开源对科研至关重要,香港大学马毅教授指出,开源模型的透明性使研究者能深入分析其工作原理。开源是科研理论和成果可复现的关键,若模型不开源,复现将困难重重。

在全球范围内,DeepSeek-V3和R1在短短几周内,就被大量研究人员应用。在知名开源平台Hugging Face 上,许多国际学者基于DeepSeek-R1开源模型训练自己的推理模型,R1的下载量已超400万次,获赞9000多个,在所有模型中位居榜首。

DeepSeek 实现的平权,让科研人员能够更自由地应用人工智能,开源让他们自主掌控自己的数据和研究结果,这些点燃了科研市场的热情。有行业人士预测,未来几年,AI for Science将迅速重塑高校和科研院所的竞争格局,没有AI for Science的实验室可能会逐渐被淘汰。

02

AI for Science仍有三大“致命伤”

虽然DeepSeek点燃了高校和科研院所的热情,但包括它在内的大模型,在AI for Science领域的落地门槛仍较高。目前主要有三大瓶颈:

第一,AI人才依然高度短缺。根据麦肯锡报告,到2030年,中国AI专业人才需求预计将达到600万,而人才缺口可能高达400万。尤其是高端复合型人才,懂AI的人不懂科研,懂科研的人不懂AI,这给AI for Science走向深水区和价值发挥,带来挑战。

第二,高校科研基础设施不足,算力短缺且资源碎片化问题依然突出。

DeepSeek虽然大幅降低了算力消耗,但对于尖端的AI for Science,仍需大量算力。而且,一个核心变化是,科研垂类模型训练从之前的微调,走向强化学习方式。比如,通过DeepSeek-R1结合垂类数据,生成一个带思考链路的模型,这导致在算力需求上,产生了一个后训练市场。而更多师生开启模型应用探索,让高水平算力基础设施建设、资源调度难等问题,仍不容小觑。

过去,传统的高校算力建设方式,往往是不同院系、研究小组,自行采购和管理各自的计算资源,一个学校内可能存在多个小型计算集群。赛尔网络的一份报告显示,全国近2000所高等学校中,91.6%的高校未建设校级算力平台。这显然难以匹配大模型时代的要求,容易出现算力资源分散管理、忙闲不均、共享不畅等问题,拖慢科研成果产出效率。

第三,大模型的技术栈复杂。即使是目前广受欢迎的DeepSeek,在业界看来,其落地门槛仍然很高。

“DeepSeek现在有两种使用方式,云端调用和本地化部署。”一位资深行业人士告诉数智前线,前者相对简单,但更多高校客户出于数据安全需求,还是选择私有化部署。而这个过程中,其实有着大量的落地技术门槛。

“比如拿到一个开源的DeepSeek模型后,要先做算力适配,一种简单粗暴的做法是多买一些已经适配过的卡,把它给装进去,再结合用户的私有数据,去做常规的RAG或微调。”一位AI人士说,这种方式简单易操作,但成本较高,应用效果一般。

现在,高校和科研院所在探索一些新方法。比如,先将开源模型蒸馏,获得更小参数的模型,来降低算力需求,再通过强化学习而不是之前的微调和RAG,将数据训练到模型上去。而模型经过强化学习以后,可以反向指导它的深度推理质量。通过这种方法,一些用户实测将比DeepSeek拿来后直接使用,准确率高出15%~20%。

这些落地技术细节,需要更全面的技术栈、工具和服务来实现。

03

百度为AI for Science打造全栈“武器库”

针对高校AI for Science的难题,业界正从过去单纯追求“堆算力”,转而追求一个更高效的系统。

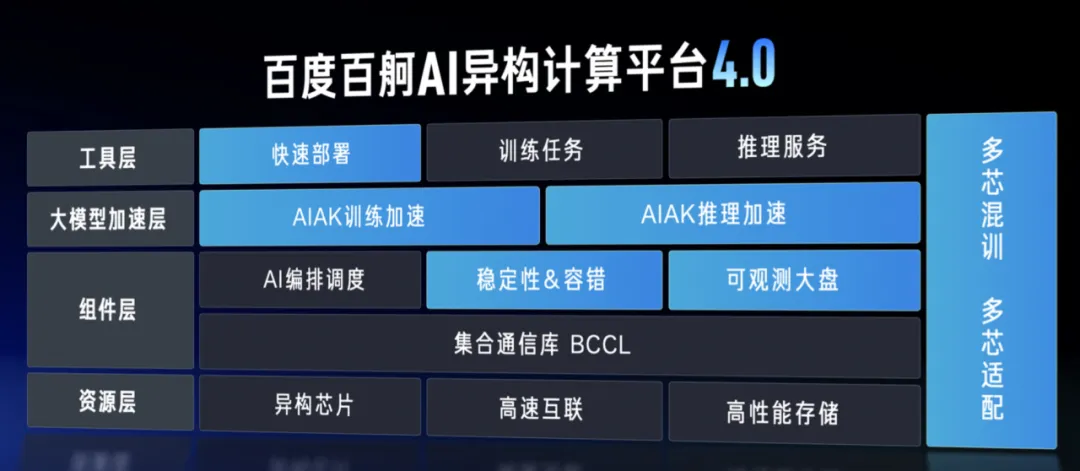

在这方面,百度已提供更全栈化的支持。从国产自主昆仑芯万卡集群,到百舸异构算力平台的算力调度中枢,再到飞桨深度学习框架和千帆大模型平台的有力支持,以及产学研协同创新,百度的举措正在直击高校的痛点。

在国产自主昆仑芯万卡集群上:

• 昆仑芯 P800 万卡集群成功点亮,且3万卡集群也将逐步点亮。

• 随着业界大模型向MoE架构转变,昆仑芯P800对MoE架构适配度更高,其显存规格比同类主流GPU高出20%-50%。昆仑芯与文心大模型、DeepSeek 全系列模型深度适配,计算效率出色。

• 搭载昆仑芯 P800 的百舸一体机,针对客户需求,一键部署、开箱即用,单机8卡就能运行671B DeepSeek满血版模型,率先支持DeepSeek采用的8bit推理,助力模型训练与微调。

• 在能效比上,昆仑芯 P800单位算力功耗降低 40%,为清华大学千亿参数模型训练每年节省300万元电费。

• 昆仑芯拥有完全自主知识产权体系,从指令集架构到编译器工具链全栈可控,保障敏感领域研究的数据安全。

在百舸异构算力平台上:

• 百舸提供从集群创建到推理的一站式解决方案,打造 “多、快、稳、省”AI 基础设施。

• 面对高校多课题组、多任务类型的复杂需求,百舸以创新架构高效统筹算力资源。其核心智能调度算法包含三大创新:基于强化学习的动态资源预测模型,提前 24 小时预判算力需求波动;跨集群任务迁移技术,实现全局负载均衡;异构资源感知调度器,将不同计算任务精准匹配最优硬件组合。经百舸优化,上海交大 GPU 利用率从35%提升至72%,任务排队时间减少60%。

• 配合DeepSeek的高水平推理能力,既保障服务稳定可靠,又大幅降本增效。

• 百舸在物理层兼容多元算力芯片,资源层提供容器化算力单元,服务层支持多种调度系统。

• 采用 “科研算力银行” 新模式,以算力积分制度、弹性竞价机制和预留实例组合,保障重点项目供给,提高碎片化资源利用效率,助力浙江大学某重点实验室提前 3 个月完成气象大模型迭代。

在飞桨深度学习框架中:

• 飞桨是国内首个开源开放的产业级深度学习平台,自2019年布局AI for Science领域,构建三层资源体系,开源社区沉淀超60万个科研项目案例,并提供主流模型和经典案例供复用。

• 内置高性能算子库,提升科研开发效率,还推出专用模块降低上手门槛,如生物计算平台 “螺旋桨 PaddleHelix” 等。

• 飞桨发表多篇世界级科研成果,如在生物计算领域发表1 篇Nature正刊,3 篇Nature 子刊。

• 独特的产学研协同创新机制,吸引200余所高校参与技术共建,如某大学基于飞桨研发的遥感图像解译系统,经社区协作优化,农作物分类准确率从89%提升至96%。

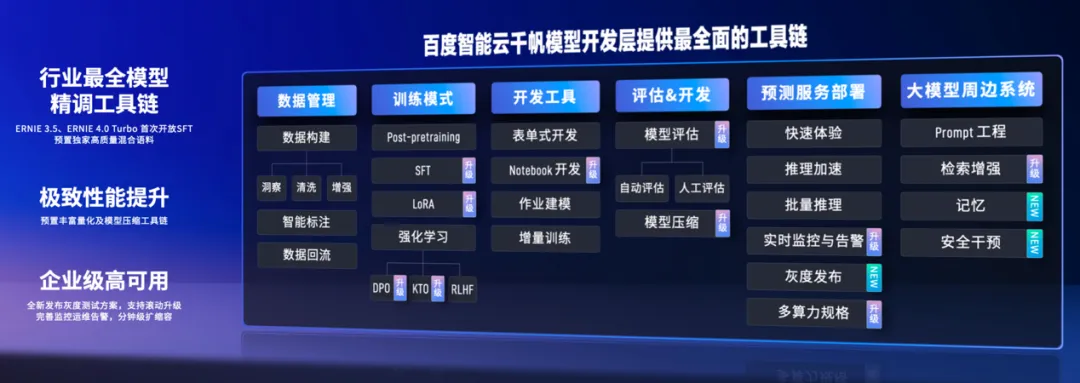

在千帆大模型平台上:

• 针对科研模型管理中难共享、难复用、难追溯的 “三难” 问题,构建全流程管理系统,保障实验可复现,已落地多个科研场景。

• 模型安全中心提供对抗样本检测等功能,保障敏感领域研究安全。

• 为高校提供全流程工具链支持,包含数据处理、模型蒸馏、强化学习、模型精调、模型评估、模型量化等关键环节。平台大模型矩阵丰富,支持DeepSeek-V3和R1 、文心大模型等,打造开放敏捷科研环境。

• 千帆开创 “模型联邦” 新机制,借助区块链技术和联邦学习架构,搭建跨机构模型集市,助力中山大学附属医院联合多家医疗机构,建立跨区域医疗影像分析联盟,在不共享原始数据的情况下,联合训练出肝癌识别准确率达98%的行业标杆模型。

在产学研协同创新上:

百度智能云与高校的合作已形成多层次、立体式的新型校企合作机制。

• 基础设施共建:与清华大学共建 “东方” 智算中心,部署 2000+卡规模昆仑芯集群。

• 课程合作:与清华、北大等多所高校专家,开设《飞桨Alfor Science前沿系列讲座课程》和《飞桨Alfor Science代码入门与实操》等课程。

• 平台搭建:与上海交通大学联合打造国内首个AI for Science科学数据开源开放平台,共同发布白玉兰科学大模型2.0。

• 人才培养:通过 “松果计划”已培养5000余名AI工程化人才,助力发表300多篇顶会论文,孵化20余个创新项目,如复旦大学文物数字孪生系统用于敦煌壁画保护、电子科大建立帕金森病例数据库及辅助诊疗评价系统、香港科大(广州)极端天气智能预报模型。

04

百度联合18+高校实战案例

在百度的全栈“武器库”助力下,高校领域已经跑出了不少实战案例。

注:文/牛慧、周享玥,文章来源:数智前线,本文为作者独立观点,不代表亿邦动力立场。

文章来源:数智前线